最大似然估计

最大似然估计学习笔记

为什么需要极大似然?

贝叶斯公式中先验概率的估计较简单,1、每个样本所属的自然状态都是已知的(有监督学习);2、依靠经验;3、用训练样本中各类出现的频率估计。

类条件概率的估计(非常难),原因包括:概率密度函数包含了一个随机变量的全部信息;样本数据可能不多;特征向量x的维度可能很大等等。总之要直接估计类条件概率的密度函数很难。解决的办法就是,把估计完全未知的概率密度转化为估计参数。这里就将概率密度估计问题转化为参数估计问题,极大似然估计就是一种参数估计方法。当然了,概率密度函数的选取很重要,模型正确,在样本区域无穷时,我们会得到较准确的估计值,如果模型都错了,那估计半天的参数,肯定也没啥意义了。

重要前提:训练样本的分布能代表样本的真实分布。每个样本集中的样本都是所谓独立同分布的随机变量 (iid条件),且有充分的训练样本。

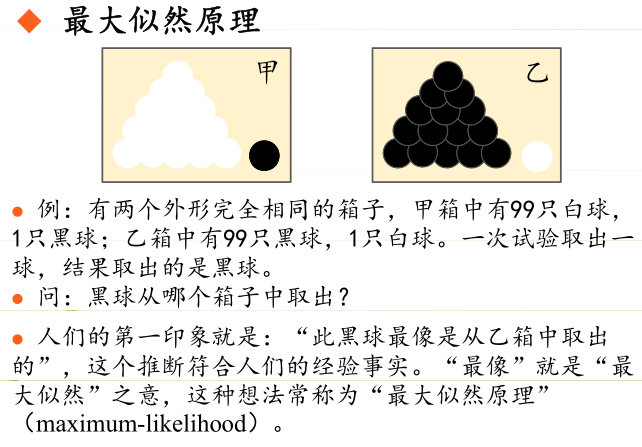

极大似然估计的原理

极大似然估计的原理, 用一张图片来说明,如下图所示:

总结起来,最大似然估计的目的就是:利用已知的样本结果,反推最有可能(最大概率)导致这样结果的参数值。

原理:极大似然估计是建立在极大似然原理的基础上的一个统计方法,是概率论在统计学中的应用。极大似然估计提供了一种给定观察数据来评估模型参数的方法,即:“模型已定,参数未知”。通过若干次试验,观察其结果,利用试验结果得到某个参数值能够使样本出现的概率为最大,则称为极大似然估计。

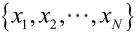

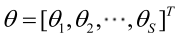

由于样本集中的样本都是独立同分布,可以只考虑一类样本集D,来估计参数向量θ。记已知的样本集为:

似然函数(linkehood function):联合概率密度函数 称为相对于

称为相对于 的θ的似然函数。

的θ的似然函数。

如果 是参数空间中能使似然函数

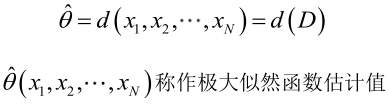

是参数空间中能使似然函数 最大的θ值,则应该是“最可能”的参数值,那么就是θ的极大似然估计量。它是样本集的函数,记作:

最大的θ值,则应该是“最可能”的参数值,那么就是θ的极大似然估计量。它是样本集的函数,记作:

求解极大似然函数

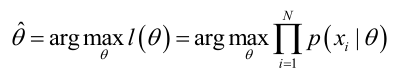

ML估计:求使得出现该组样本的概率最大的θ值。

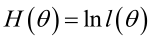

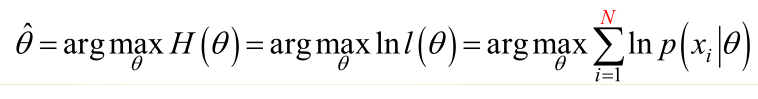

实际中为了便于分析,定义了对数似然函数:

- 未知参数只有一个(θ为标量)

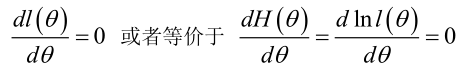

在似然函数满足连续、可微的正则条件下,极大似然估计量是下面微分方程的解:

- 未知参数有多个(θ为向量)

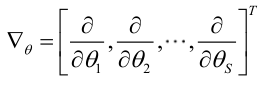

记梯度算子:

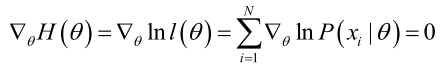

若似然函数满足连续可导的条件,则最大似然估计量就是如下方程的解。

方程的解只是一个估计值,只有在样本数趋于无限多的时候,它才会接近于真实值。

极大似然估计的例子

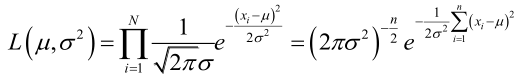

例1:设样本服从正态分布 ,则似然函数为:

,则似然函数为:

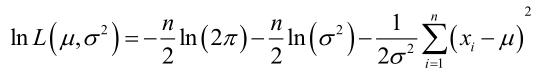

它的对数:

它的对数:

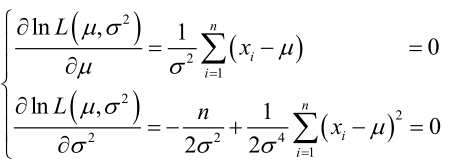

求导,得方程组:

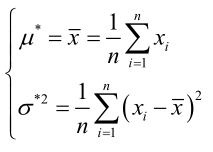

联合解得:

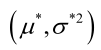

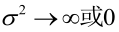

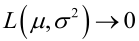

似然方程有唯一解 :,而且它一定是最大值点,这是因为当

:,而且它一定是最大值点,这是因为当 或

或 时,非负函数

时,非负函数 。于是U和

。于是U和 的极大似然估计为

的极大似然估计为 。

。

总结

求最大似然估计量 的一般步骤:

的一般步骤:

写出似然函数;

对似然函数取对数,并整理;

求导数;

解似然方程。

最大似然估计的特点:

- 比其他估计方法更加简单;

- 收敛性:无偏或者渐近无偏,当样本数目增加时,收敛性质会更好;

- 如果假设的类条件概率模型正确,则通常能获得较好的结果。但如果假设模型出现偏差,将导致非常差的估计结果。